近日,福州大学数字中国研究院(福建)李蒙蒙研究团队在遥感领域顶级SCI期刊《IEEE Transactions on Geoscience and Remote Sensing》上发表“匹配街景图像与高分辨率遥感影像的城市土地利用分类”(Matching Street View Images for the Classification of Urban Land Use From Very-High-Resolution Remote Sensing Images)的研究成果。论文第一作者为2023级硕士研究生俞哲耀,通讯作者为李蒙蒙副研究员,主要合作者为福州大学物理与信息工程学院郑向涛研究员。

研究成果的主要内容为:

一、研究意义和问题

城市土地利用分类是支撑国土空间精细化监测、城市规划与治理现代化的重要基础。卫星遥感作为获取大尺度空间信息的核心手段,已广泛应用于土地覆盖识别与变化监测。然而,土地利用本质上反映的是地表要素的功能属性,在高密度、高异质的城市区域,单一俯视视角的遥感影像难以充分刻画土地利用单元内部复杂的功能语义,尤其在商业用地和公共管理与服务用地等类型的识别上长期存在精度瓶颈。街景图像作为重要的开放地理信息数据源,能够从地面视角直接感知建筑形态、商业活动与街道环境特征,为城市土地利用功能表达提供关键且互补的语义信息。将街景图像引入遥感土地利用分类,有望突破传统方法在功能属性表征方面的局限,显著提升分类精度与区分能力。

街景图像与高分辨率遥感影像在成像视角与空间表达方式上存在本质差异:前者为近地斜视,后者为垂直俯视。视角不一致性导致二者在几何结构、语义表达和空间位置上存在显著错位,致使跨视角影像的自动匹配与有效融合面临挑战。如何跨越视角差异,实现街景与遥感影像的可靠匹配与协同建模,是提升城市土地利用分类精度亟需解决的核心科学问题。

二、创新方法

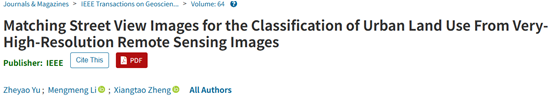

针对街景图像与遥感影像的跨视角匹配问题,该研究提出了一种多粒度空间自动对齐算法。具体为,通过空间位置约束,建立有限视场下街景图像与遥感影像的粗略对齐关系,并构建视角变换模型(图1),弥合图像间几何结构的差异,使得神经网络能学习图像特征

图1 视角变换模型

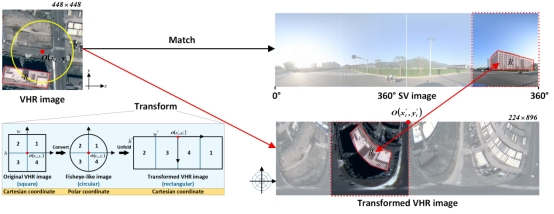

间的对齐关系。采用特征分层策略来聚焦街景图像与遥感影像特征之间的局部相关性,并结合类注意力机制,动态调整整体和局部特征间的相关性关系。这种方法有效减少了复杂城市环境对图像匹配的干扰,实现街景图像与遥感影像在地理空间上的精确对齐。

针对匹配后的街景图像和遥感影像特征融合问题,基于Sinkhorn算法在特征空间中对齐街景图像和遥感影像的语义特征,以减少由于视角不一致性造成的跨视角图像在语义表达上的差异,显著提高了模型在土地利用分类中的准确性。本研究所提的街景图像匹配遥感影像的城市土地利用分类技术流程见图2。

图2 街景图像匹配遥感影像城市土地利用分类技术流程

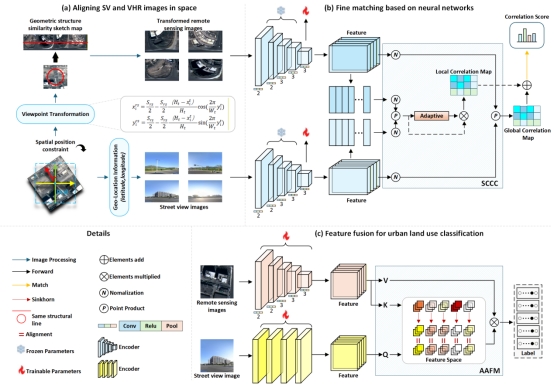

三、公开数据集

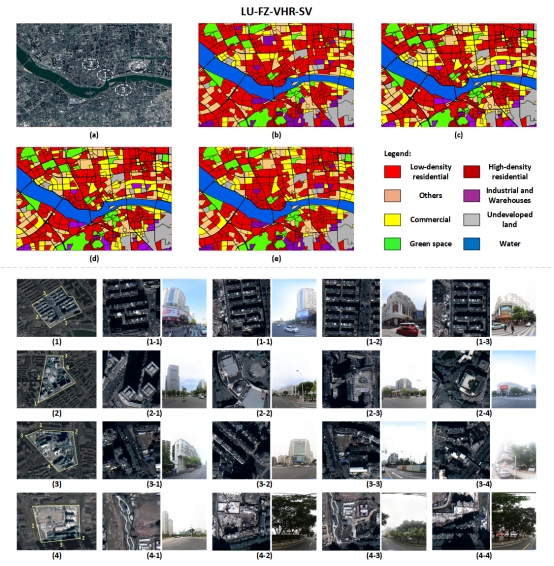

针对街景图像与遥感影像匹配数据集缺乏的问题,研究团队制作并公开了两个街景图像匹配遥感影像的城市土地利用数据集(图3):LU-FZ-VHR-SV和LU-ZZ-VHR-SV数据集(https://www.github.com/diolock777/LU VHR SV Datasets)。LU-FZ-VHR-SV数据集中遥感影像使用福州主城区GF-2高分辨卫星影像,空间分辨率为0.8米;LU-ZZ-VHR-SV数据集中遥感影像使用郑州主城区Worldview-3高分辨卫星影像,空间分辨率为0.3米。街景图像由百度地图获取。数据集参照中国国家土地利用分类标准(GB/T 21010-2017)并根据城市土地利用的实际情况进行标注。

图3 LU-FZ-VHR-SV和LU-ZZ-VHR-SV数据集

四、实验结果

实验结果表明:匹配街景图像与遥感影像的城市土地利用分类性能显著优于单纯依赖遥感影像的分类方法,尤其在类间相似度高且类内变异较大的城市土地利用单元中表现较为突出。此外,基于特征分层策略的动态相关性计算方法在跨视角图像匹配任务中性能优于直接计算相关性和基于滑动窗口计算相关性的方法;在特征空间对齐特征后进行特征融合的方式,较之直接融合特征或基于绝对空间线索对齐后融合特征的方式,效果更优。

图4 福州城区土地利用分类图

五、引用格式

Z. Yu, M. Li* and X. Zheng, “Matching Street View Images for the Classification of Urban Land Use From Very-High-Resolution Remote Sensing Images,” in IEEE Transactions on Geoscience and Remote Sensing, vol. 64, pp. 1-18, 2026, Art no. 4400318, doi: 10.1109/TGRS.2025.3646611.